L’étape qui suit le mécanisme d’attention multi-têtes consiste en le Feed-Forward Network. Ici, nous avons la partie la plus complexe et la plus importante.

En effet, il s’agit pour l’intelligence artificielle de faire semblant de comprendre que les choses ne se passent pas de manière linéaire.

Faire semblant, car seul le matérialisme dialectique peut saisir le principe du bond en avant, du saut qualitatif, de la rupture, de la révolution, du développement inégal.

Voici comment l’intelligence artificielle qui suit Transformer opère à ce niveau, mais ce n’est qu’une présentation sommaire, qui exige encore une véritable étude approfondie, avec un très haut niveau de connaissances mathématiques.

Cela n’empêche pas du tout d’en saisir, en attendant, le concept général, l’approche employée.

Le Feed-Forward Network, c’est en français le réseau à propagation avant. C’est une démarche qui a été accouplée à la rétropropagation.

En fait, l’idée est simple. Auparavant, on se disait que pour comprendre une phrase, il fallait avancer mot par mot.

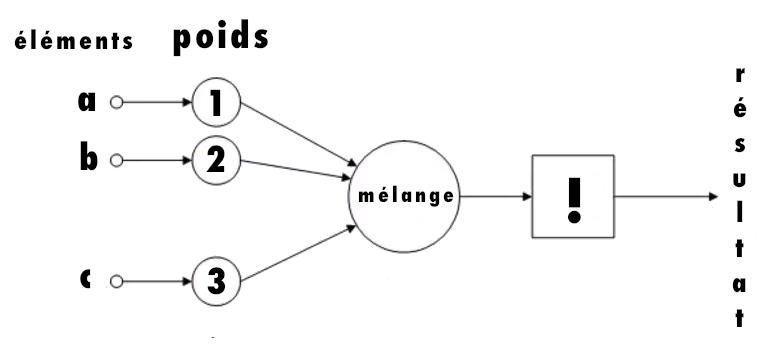

On a donc une analyse d’un mot, puis l’analyse d’un second mot, et la seconde analyse est ramenée à la première, on mélange le tout, puis on va au troisième mot, qu’on analyse et on ramène cela au mélange obtenu précédemment, et ainsi de suite.

C’est une logique séquentielle, et le modèle Transformer ne procède pas ainsi. Il va seulement vers l’avant.

Ses concepteurs considèrent que de toutes façons, le mécanisme multi-têtes a vu ce qu’il y avait à voir, donc il faut avancer directement.

Seulement voilà, le mécanisme multi-têtes résume les interconnexions sous la forme de vecteurs et certains peuvent être négatifs.

Du point de vue matérialiste dialectique, ce qui est négatif est très intéressant, mais pas du point de vue de l’intelligence artificielle.

Les vecteurs négatifs sont ainsi ramenés à zéro, pour se débarrasser d’eux.

Par exemple, le chat est solitaire, cela peut fournir un vecteur négatif : celui-ci est ramené à zéro, afin de ne pas troubler l’expression positive.

Il y a alors un souci : si on supprime la négation, alors on supprime la qualité. On a ici la clef du problème de l’intelligence artificielle suivant le modèle Transformer.

Le modèle Transformer dit ici : on s’en moque, car avec les statistiques on peut déjà savoir à l’avance ce qui est correct et ce qui ne l’est pas. En clair : les nuances passent à la trappe !

Mais nous savons que les nuances permettent le contraste, le contraste la différence, la différence la lutte, la lutte la transformation.

L’intelligence artificielle ne se tourne pas vers cela ; elle a ici le même raisonnement mécanique que l’expérimentation animale, qui constate qu’une chose « fonctionne » et qui s’arrête là.

L’intelligence artificielle n’est pas seulement uniquement capable de représenter de manière figée le monde : elle en supprime également des nuances.

C’est la critique principale qu’on doit faire.

Reste cependant que la qualité est présente dans le positif également.

Il y a donc une opération de tricherie généralisée qui est mise en place dans le modèle Transformer.

Les données sont en effet passées à la moulinette de la fonction d’activation non linéaire (comme ReLU, Sigmoid, Tanh, GELU).

Cela sert à éviter de se retrouver avec de simples lignes droites partout dans l’évaluation des données.

Par exemple, s’il est écrit que quelque chose est « incroyablement intéressant », le rapport entre les deux mots ajoute une qualité, ce n’est pas simplement plus qu’intéressant, il y a un saut qualitatif.

Pour représenter une telle chose, il faut des courbes. C’est que les choses ne vont pas en ligne droite !

Mais la rectification se fait donc ici de manière artificielle.

La science trouverait en amont de telles courbes ; l’intelligence artificielle les place après avoir accumulé les statistiques et utilise les courbes pour les décrire.

C’est là où on se souvient qu’effectivement, l’intelligence artificielle ne « pense » pas, mais ne fait que redire ce qui a été dit.

C’est une super-machine pour retranscrire, mais elle n’est pas capable de dire ou faire autre chose que ce qui a déjà été dit ou fait, d’une manière ou d’une autre.

Prenons un exemple, en s’appuyant la cuisine. On veut faire une sauce vinaigrette, avec de l’huile d’olive, du vinaigre balsamique, de la moutarde, du poivre et du sel.

On prend chaque ingrédient dans une certaine quantité, dans une certaine proportion par rapport aux autres ; on en a l’habitude.

On procède en ajoutant progressivement de l’huile, pour mettre le poivre à la fin, lorsque l’ensemble est bien homogène.

Il faut donc observer le processus au fur et à mesure qu’on ajoute de l’huile, on peut goûter et quand on goûte, on évalue en fonction de ce qu’on connaît.

Et on se dit alors que ce n’est pas encore prêt, qu’il faut encore ajouter de l’huile ou non, etc.

L’intelligence artificielle procède pareillement avec Transformer.

La prise des éléments, c’est l’embedding.

L’attribution de poids, c’est le mécanisme multi-têtes.

On a alors un gros objet mathématique, dont les fondements sont l’accumulation énorme de statistiques effectuée au préalable.

On va alors de l’avant, quitte à supprimer ce qui est négatif, parce qu’on veut un résultat à tout prix.

Mais pour vérifier, on utilise la rétropropagation, c’est-à-dire une autocorrection.

On comprend aisément l’idée avec une reconnaissance d’une image : imaginons qu’après être passé à travers les différentes étapes, il est calculé que cela représente à 80 % un hamster, à 20 % un cochon d’Inde, au lieu du vrai résultat qui est un cochon d’Inde.

L’intelligence artificielle enregistre qu’elle s’est trompée et va faire une sorte de grand mouvement en arrière pour chercher les tendances erronées dans le calcul qui ont amené ce résultat et non l’autre.

Une fois que l’erreur est corrigée, elle est enregistrée, afin de ne pas se retrouver dans la même situation par la suite.

Cela fait que plus une intelligence artificielle est employée, plus elle apprend.

C’est l’intérêt des modèles gratuits : ils entraînent l’intelligence artificielle.

Par contre, lorsque l’IA répond, elle n’est pas en mesure de faire une rétropropagation.

Cette dernière ne peut avoir lieu que durant les entraînements.

C’est ainsi fait, car c’est moins lourd dans le fonctionnement et afin de « neutraliser » les réponses.

Car telle est la logique de l’intelligence artificielle qu’elle fournit toujours des résultats, toujours des résultats positifs.

Ce n’est pas seulement qu’elle fournit des résultats – c’est ainsi qu’elle est vendue commercialement – c’est qu’elle ne sait faire que ça !

-> Retour au sommaire du dossier sur

L’intelligence artificielle, prolongement de la cybernétique