L’Histoire est marquée par le combat entre le nouveau et l’ancien, mais il n’existe pas une muraille de Chine entre les deux.

L’ancien est marqué par le nouveau, le nouveau par l’ancien, dans la mesure déjà où le nouveau s’arrache à l’ancien et l’ancien fait face au nouveau.

Pour cette raison, quelqu’un qui est happé par l’un ou par l’autre peut, en réalité, s’imaginer ne pas l’être, et même relever de son opposé.

La tension est tellement extrême que, les contraires se convertissant l’un en l’autre, il y a une confusion.

Prenons la première situation, où quelqu’un qui relève de l’ancien s’imagine appartenir au nouveau.

Cette personne s’identifie au nouveau ; elle considère que le nouveau va triompher de l’ancien, que ce dernier est quelque chose de négatif, faisant obstruction au progrès historique.

C’est le nouveau qu’il faut porter.

Toutefois, ce qui confère une dynamique à cette personne, ce n’est pas une réelle appartenance au nouveau, mais une compréhension de la dimension dont relève le nouveau.

Cette personne appartient, dans les faits, à l’ancien, mais sa position est tellement condamnée historiquement qu’elle parvient à une vision réelle de cette condamnation.

Pour cette raison, elle s’identifie au nouveau afin de sauver sa situation particulière.

Or le nouveau repose sur l’universel, pas le particulier.

Le choix particulier du bourgeois qui rejoint la Cause révolutionnaire est en contradiction avec la dimension universelle de celle-ci.

Il y a ici traîtrise, car les intérêts particuliers sont reconnus et confondus avec les intérêts universels.

Avec l’accentuation des contradictions historiques, la tension entre l’aspect particulier et l’aspect universel devient toujours plus grande.

Dans les moments de crise, il se révèle alors la nature de cinquième colonne de ceux qui prétendent rejoindre la Cause révolutionnaire, mais agissent en fait comme avant-postes de la contre-révolution.

L’expression « cinquième colonne » date d’octobre 1936 ; ce sont les communistes qui l’ont popularisé en Espagne.

Ils avertissaient alors que, dans le cadre de la guerre civile, les nationalistes revendiquaient quatre colonnes militaires lancées contre Madrid, et une « cinquième colonne » déjà présente sur place, et agissant de manière masquée.

Les communistes espagnols avaient, en pratique, compris que cette « cinquième colonne » ne consistait pas simplement en des agents secrets, des espions, des saboteurs envoyés par l’ennemi.

Ils ont réussi à voir qu’il s’agissait, en réalité, de ceux qui agissaient en convergence avec le camp des nationalistes.

L’ultra-gauche, principalement le parti POUM, appelait à refuser une armée professionnelle, à attaquer la petite-bourgeoisie, à précipiter la socialisation des entreprises.

Sous une apparence très radicale, très révolutionnaire, on avait des mots d’ordre qui œuvraient au niveau pratique à diviser le camp antifasciste, à saboter les améliorations, à saper le moral général de la population.

Une personne connue qui a participé au POUM est l’écrivain britannique George Orwell ; quelques années plus tard, il écrivait le roman violemment anticommuniste « 1984 ».

Ce qu’on y trouve est exemplaire d’une production intellectuelle de la part de quelqu’un qui a compris le communisme, l’a rejoint mais sur une base d’ultra-gauche, pour ensuite revenir dans le camp capitaliste, en prétendant conserver une dimension « révolutionnaire ».

C’est caractéristique de la cinquième colonne : celle-ci prétend toujours représenter la pointe de la révolution, pour en réalité porter des positions qui visent à saboter de l’intérieur le camp révolutionnaire.

Le trotskisme a été, en URSS, une telle cinquième colonne, parmi d’autres courants politiques.

C’est cela qui n’a pas été compris par les observateurs occidentaux des fameux « procès de Moscou » dans la seconde moitié des années 1930.

Il a été considéré par les journalistes bourgeois, de manière erronée, que les aveux des accusés avaient été extorqués, puisqu’ils assumaient d’avoir joué un rôle contre-révolutionnaire, condamnaient leur propre parcours, acceptaient leur condamnation.

Ils n’ont pas compris qu’on parle ici d’individus qui se sont retrouvés prisonniers dans le nexus du combat entre le nouveau et l’ancien ; ils ont agi comme agents de l’ancien au sein du nouveau, sans même s’en apercevoir.

Ils se sont imaginés être hyper-révolutionnaires, lutter au service de la Cause de la manière la meilleure, alors qu’ils agissaient comme des saboteurs.

Toute ligne rouge connaît, de manière inéluctable, un tel phénomène.

Elle développe le nouveau, ce qui provoque un « écho » dans l’ancien, et des éléments se détachent alors de l’ancien pour rejoindre le nouveau.

Ils sont cependant le vecteur de l’ancien ; ils sont une action de l’ancien pour briser le nouveau.

Cela suit le principe qui veut qu’il existe trois moyens pour l’ancien de combattre le nouveau : d’abord en niant son existence, ensuite en le combattant, enfin en prétendant le rejoindre pour le combattre de l’intérieur.

Mao Zedong a compris cela et c’est pour cela qu’il a appelé à lancer une Grande Révolution Culturelle Prolétarienne en Chine populaire, afin de chasser du Parti Communiste les éléments agissant comme les vecteurs de l’ancien.

Ce fut là bien entendu un processus de tension extrême et un excellent exemple de cela est que celui qui a mis en avant le « petit livre rouge », le général Lin Piao, était en fait lui-même en réalité quelqu’un agissant comme cinquième colonne.

Le principe d’agiter le drapeau rouge contre le drapeau rouge est inévitablement utilisé par des éléments « ultra-radicaux » venus de l’ancien pour saboter le nouveau.

En France, dans la seconde partie des années 2010, est apparu un « Parti Communiste Maoïste », qui a revendiqué la guerre populaire : il a disparu du jour au lendemain au moment de la pandémie, en 2020, après avoir joué le rôle de provocateur et de serviteur de la confusion.

Mais il faut comprendre qu’il y a également le mouvement contraire.

Il y a des éléments politiques qui devraient se tourner vers le nouveau, mais qui rejoignent l’ancien.

Ils se trompent de camp, et ils sont même d’autant plus contre le Communisme qu’ils en relèvent en réalité.

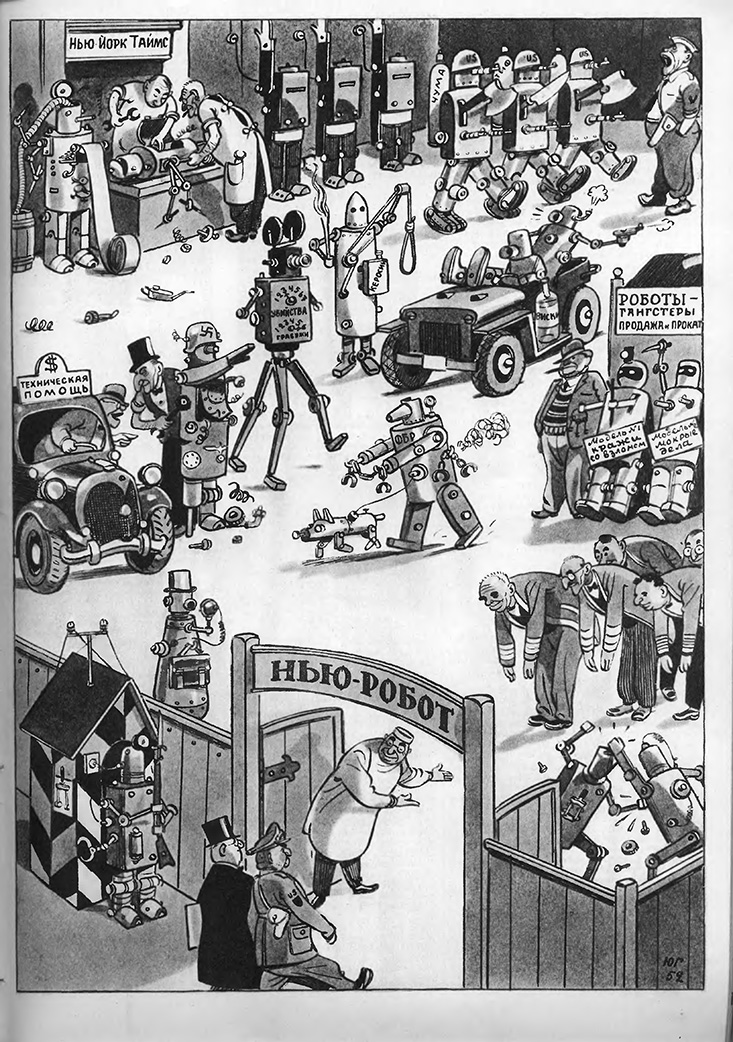

On parle ici de prolétaires qui sont manipulés par le capitalisme par l’intermédiaire du fascisme.

Le fascisme cherche toujours à s’approprier une image révolutionnaire, en puisant dans l’idéologie communiste sur le plan des apparences.

Cette élaboration du fascisme est produite par des intellectuels opportunistes, mais également par des prolétaires sincères qui sont cependant corrompus à différents niveaux, incapables d’aller jusqu’au bout de leur démarche.

Il ne s’agit donc pas d’une « cinquième colonne » de la révolution dans le camp de la contre-révolution : une telle chose ne peut pas exister.

Il n’existe pas choses telles que le « nazisme de gauche », le « fascisme de gauche », le « nationalisme de gauche », etc.

Ce ne sont que des fantasmagories ayant convergé avec la contre-révolution, qui se sont mises à son service, et qui sont le plus souvent mises de côté après avoir été utilisées.

Ce qui compte, c’est de raisonner en brise-glace.

Le Parti porte le matérialisme dialectique, il suit les enseignements de Marx, Engels, Lénine, Staline, Mao Zedong.

Il ne fige pas sa proposition révolutionnaire, mais accompagne le mouvement historique, les transformations, en portant la ligne rouge.

Portant le nouveau, il sait que l’ancien va tenter de le freiner, par différents moyens.

Ces moyens sont la conspiration du silence et l’affrontement, qui sont clairement visibles, mais il y a également l’envoi de gens « sincères » qui portent les valeurs de l’ancien afin de détruire tout depuis l’intérieur.

Il faut ici se souvenir du mot de Joseph Staline : les meilleures forteresses se prennent de l’intérieur.

Le Parti doit donc toujours être à la hauteur de la subjectivité révolutionnaire ; il sait qu’il y aura des agents ennemis qui voudront l’infiltrer, soit en toute connaissance de cause, car il s’agit d’agents, soit de manière « sincère » mais en réalité en pleine convergence avec la contre-révolution.

Le Parti doit se méfier, par définition, toujours se méfier ; il sait avec Mao Zedong que ceux qui agitent des drapeaux rouges ne sont, en attente de la preuve du contraire, que des gens qui agitent des drapeaux rouges.

Il faut savoir prouver le caractère authentique de l’engagement, et cela à travers les différentes phases du processus révolutionnaire.

Le Parti de la révolution, portant le matérialisme dialectique, porte donc une grande attention à ce qui relève de la cinquième colonne et qui cherche à converger avec la contre-révolution ; de la même manière, il surveille les agents faussement révolutionnaires qui agissent dans le camp ennemi pour lui donner une image « révolutionnaire »

>>Revenir au sommaire des articles

sur le matérialisme dialectique